Что такое гугл бот

Как найти и обезвредить фейкового гуглбота

В прошлом месяце агентство Incapusla Security представило отчет о состоянии гуглботов и их вредоносных близнецов. И надо сказать, для тех, чей бизнес зависит от статистики сайта, новости не очень хорошие.

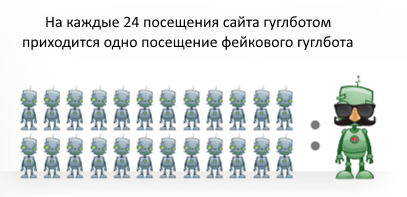

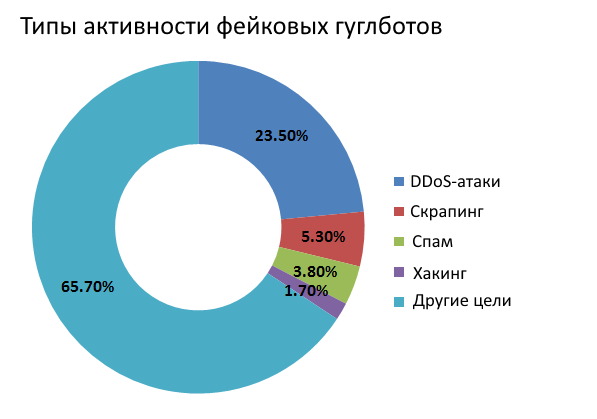

Из 24 посещений сайта гуглботами одно обязательно совершает фейк. При этом более 34% фейковых гуглботов используются для DDoS-атак, взломов, спама и других вредоносных действий.

Методология

Эксперты Incapusla проанализировали:

«. более 400 млн посещений роботами поисковых систем 10 тысяч сайтов, в результате которых было проиндексировано 2,19 млрд страниц в течение 30 дней.

Информация о гуглботах-самозванцах (фейковых гуглботах) получена вследствие проверки более 50 млн посещений гуглботов-самозванцев, а также из отчета DDoS Threat Landscape, опубликованного ранее в этом году».

Выводы Incapusla

Когда Incapusla обратили внимание на стандартного гуглбота, то заметили некоторые интересные моменты.

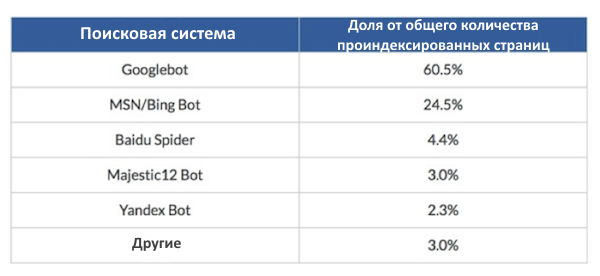

Для начала следует отметить, что гуглботы сканируют больше страниц, чем роботы всех других поисковых систем вместе взятые, — 60,5%.

То, что Incapusla обнаружили при анализе этих посещений, также было немного неожиданно:

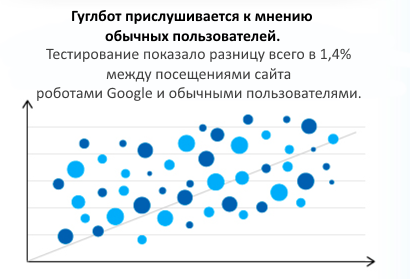

Известно, что Google — крупнейший генератор посещений ботов и что эти посещения инициируются чем-то иным, нежели активностью сайта или SEO, и что он прислушивается к мнению пользователей.

В целом, довольно неплохо. Но беспокойство вызывает не Google, а его «злые» близнецы, с которыми следует быть осторожнее (их очень много — и некоторые их них отлично сделаны).

Юзер-агенты

Mozilla/5.0 (Macintosh; Intel Mac OS X 10.9; rv:30.0) Gecko/20100101 Firefox/30.0

Эта информация говорит, что кто-то использует Mozilla/Firefox 30 на MacIntoch с операционной системой Mavericks. Она также может рассказать о пауках, программах и ботах, то есть о тех, кто «бегает» по нашим сайтам.

Имитация Google — жизнь бота

В ходе исследования Incapusla обнаружили, что «более 4% ботов, представляющихся гуглботом, на самом деле им не являются». И здесь победителем становится Бразилия с долей фейковых гуглботов почти 14%.

Плохие боты

Зачем кому-то создавать фейковых гуглботов?

Это что-то вроде того, как иметь поддельные документы в 18 лет. Иногда вы просто хотите потусоваться, но чаще они нужны вам, потому что вы делаете что-то такое, о чем лучше не знать вашей маме.

Не все боты плохие

Примите во внимание, что не все боты плохие и созданы со злым умыслом. Иногда фейковых гуглботов используют только для того, что посмотреть на ваш сайт глазами Google.

Поэтому прежде чем блокировать бота, обратите внимание на его поведение. Может, он всего лишь просматривает сайт? Заходит ли он снова и снова, имеют ли его перемещения случайный характер?

И только после того как вы определите, что это плохой бот, можно закрыть ему доступ. Будьте осторожны, так как вы можете заблокировать доступ и для роботов Google.

Как узнать, что посещения фейковые?

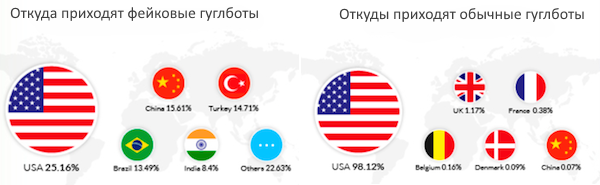

Одним из ключевых показателей, указывающих на то, что есть проблемы с фейковыми гуглботами, является страна происхождения бота.

На американские сайты чаще всего заходят боты из 6 стран, показанных на картинке справа. А вот боты, чья родина указана на изображении слева, должны заставить владельца ресурса насторожиться. Однако если вы работаете со странами из списка слева, то нет ничего странного в том, что ваш сайт будут посещать их гуглботы.

Если вы увидели что-то подозрительное, то не забудьте просмотреть логи сервера и юзер-агенты и проверить, совершаются ли на вас атаки. Если это так, и у вас нет доступа к серверам, свяжитесь с компанией, которая может заблокировать их за вас.

Определить плохого бота не слишком трудно

Хорошей новостью является то, что идентифицировать плохого бота не так уж сложно. И как только это будет сделано, вы можете заблокировать его и больше не пускать на свой сайт. Но это в том случае, если у вас есть такие возможности, права и доступы. У большинства владельцев сайтов всего этого нет, и им приходится полагаться на свою хостинговую компанию, поэтому очень важно выбрать надежного и осведомленного подрядчика.

Если у вас есть доступы, вы можете предпринять необходимые меры, чтобы убедиться, что боты действительно осуществляют какую-то деструктивную деятельность, а затем заблокировать их.

Как определить плохого бота?

Иногда выявить плохих ботов может быть достаточно проблематично: некоторые из них очень сложно устроены, особенно, те, которые имитируют Google. Вот некоторые шаги, которые помогут определить фейковых ботов.

Incapusla исходя из собственного опыта сформулировала 4 шага для выявления фейковых ботов:

Шаг 1. Посмотрите на данные в заголовке

Даже если боты использовали юзер-агент Google, остальные данные заголовка будут совсем «не как у Google». Этого достаточно, чтобы забить тревогу, но не торопитесь блокировать его, потому что зарегистрированы случаи, когда Google отклоняется от обычной структуры заголовка.

Шаг 2. Проверка IP и ASN

Далее проведите проверку IP и ASN. Здесь стоит обратить внимание на несколько моментов, в том числе на личности владельцев IP-адресов и ASN, которые производят подозрительный трафик.

В случае с фейковыми гуглботами ни IP, ни ASN не будут связаны с Google. Таким образом, с помощью параллельной проверки этой информации и сомнительных заголовков можно с высокой степенью уверенности сказать, что мы имеем дело с потенциально опасными двойниками.

Шаг 3. Контроль действий

Тем не менее «потенциально опасный» это не всегда «злой». Например, некоторые SEO-инструменты пытаются выдать себя за гуглботов, чтобы получить «гуглоподобное» видение контента сайта и ссылочного профиля.

Именно поэтому следующий пункт поиска — поведение посетителей. Оно поможет нам понять их намерения, ключ к которым часто лежит в самом запросе, так как они представлены в WAF (Web Application Firewall). В этом случае самого показателя посещений достаточно, чтобы завершить картину, сразу определив DDoS-атаки и повысив автоматизированную защиту от них.

Шаг 4. Репутация IP и новая низкоуровневая подпись

Хотя Incapusla регулярно сталкивается с гуглботами, вариант подписи, появившийся во время последней атаки, отраженной системой, не был частью существующей базы данных. После смягчения атаки собранные данные использовались, чтобы создать новую запись низкого уровня, которая затем будет добавлена к десятимиллионному пулу записей и разведена через сеть, чтобы защитить всех клиентов Incapusla.

В результате при следующем посещении этими ботами сайта они будут немедленно заблокированы. Более этого, репутация атакующих IP также будет записана и добавлена в другую базу данных, где хранятся потенциально опасные адреса.

Проще говоря, вы должны знать, что юзер-агенты могут быть фейками, IP-адреса могут быть подделаны, а заголовки реконструированы и т.д. И для обеспечения безопасности, нужно раскрыть «истинное лицо» и намерения посетителей.

Итоги

Следите за своим органическим трафиком, особенно за страной его происхождения. А когда кто-то или что-то путешествует по вашему сайту, узнайте, каковы его намерения, и не держите в страхе «хороших ребят».

Недавно для обеспечения удобства пользователей Google Analytics запустил фильтр ботов и пауков. Подробнее об этом можно прочитать здесь.

Googlebot

Googlebot — поисковый робот компании Google, используемый для сканирования мировой сети и пополнения поискового индекса системы Google. Робот начинает сканирование каждого отдельного сайта с получения списка URL-адресов веб-страниц, созданного по результатам предыдущих сеансов, и пополняет его данными из файлов Sitemap; просматривая страницы, робот ищет ссылки (SRC и HREF) и добавляет их в список страниц, подлежащих сканированию.

Веб-мастера могут управлять роботом с помощью команды в файле robots.txt или мета-тега ; Google в списке своих инструментов для веб-мастеров даёт возможность проверить «видение» сайта роботом. IP-адреса бота время от времени меняются.

При сканировании Googlebot указывает user-agent:

Ссылки

Председатель совета директоров: Эрик Шмидт • Директор, президент по технологиям и сооснователь: Сергей Брин • Главный исполнительный директор и сооснователь: Ларри Пейдж

Adscape • AdSense • Advertising Professional • AdWords • Analytics • Checkout • Click-to-Call • DoubleClick • Insights for Search • Trends • Wallet • Google Университет

Code • Dart • Gadgets API • GData • Go • Googlebot • Guice • GWS • Highly Open Participation Contest • Image Labeler • KML • MapReduce • Mediabot • Pinyin • SketchUp Ruby • Sitemaps (index) • Summer of Code • TechTalks • Web Toolkit • Website Optimizer

Alerts • Blogger • Bookmarks • Docs • FeedBurner • iGoogle • Jaiku • Knol • Library Project • Map Maker • Mashup Editor • Notebook • Page Creator • Sites • Video Marketplace • YouTube • Диск

Appliance • Audio • Books • Code • Desktop • GOOG-411 • Images • Maps (Mars • Moon • Ocean • Sky • Street View) • News • Patents • Products • Scholar • SearchWiki • Usenet • Video • Web

Поглощения • Цензура • Current • Критика • Earth Outreach • Foundation (Google.org) • Google China • Googleplex • История • Hoaxes • I’m Feeling Lucky • Labs • Logo • Lunar X Prize • I/O • Список сервисов и инструментов • WiFi • Zeitgeist • «Бомбы» • Гуглизм

Полезное

Смотреть что такое «Googlebot» в других словарях:

Googlebot — ist der Webcrawler der Suchmaschine Google. Dabei handelt es sich um ein Computerprogramm, das Texte und Bilder im World Wide Web herunterlädt und diese über die Web und die Bildsuche von Google auffindbar macht. Inhaltsverzeichnis 1 Arbeitsweise … Deutsch Wikipedia

Googlebot — es el robot de búsqueda usado por Google. Colecciona documentos desde la web para construir una base de datos para el motor de búsqueda Google. Si un webmaster no quiere que su página sea descargada por un Googlebot, puede insertar un texto… … Wikipedia Español

Googlebot — A Googlebot is a search bot used by Google. It collects documents from the web to build a searchable index for the Google search engine.If a webmaster wishes to restrict the information on their site available to a Googlebot, or another well… … Wikipedia

Googlebot — Les googlebots sont des robots d indexation utilisés par le moteur de recherche Google afin de recenser et indexer les pages web. La chaîne de caractères permettant de les identifier en tant que User Agent est, selon la tâche qu ils effectuent, l … Wikipédia en Français

Googlebot — ● np. m. ►WEB►MOTREC Nom du robot du moteur de recherche Google … Dictionnaire d’informatique francophone

Googlebot — Name (User Agent) des Spiders von Google. Bemerkenswert ist, dass Google die Zahl seiner Spider Anfang 2004 offenbar drastisch erhöht hat. Neu ist auch, dass ein Typ des Googlebots mit einer Mozilla Kennung unterwegs ist. Es steht zu vermuten,… … SEO Wörterbuch

Google bot — Googlebot ist der Webcrawler der Suchmaschine Google. Dabei handelt es sich um ein Computerprogramm, das Texte und Bilder im World Wide Web herunterlädt und diese über die Web und die Bildsuche von Google auffindbar macht. Inhaltsverzeichnis 1… … Deutsch Wikipedia

Robots.txt — Nach der Übereinkunft des Robots Exclusion Standard Protokolls liest ein Webcrawler (Robot) beim Auffinden einer Webseite zuerst die Datei robots.txt (kleingeschrieben) im Stammverzeichnis (Root) einer Domain. In dieser Datei kann festgelegt… … Deutsch Wikipedia

Robots Exclusion Standard — Nach der Übereinkunft des Robots Exclusion Standard Protokolls liest ein Webcrawler (Robot) beim Auffinden einer Webseite zuerst die Datei robots.txt (kleingeschrieben) im Stammverzeichnis (Root) einer Domain. In dieser Datei kann festgelegt… … Deutsch Wikipedia

User-Agent — Pour les articles homonymes, voir Agent. Un user agent est une application cliente utilisée avec un protocole réseau particulier ; l expression est plus généralement employée comme référence pour celles qui accèdent au World Wide Web. Les… … Wikipédia en Français

Чат-бот Google ответил на главные вопросы жизни, вселенной и вообще

Исследователи компании Google придумали способ, как научить чат-бота отвечать по-человечески, и попытались поговорить с ним за жизнь. Если совсем коротко — бот оказался аморальной женщиной с непростым характером.

Люди в Google попытались поговорить: с машиной. Результаты эксперимента под названием «A Neural Conversational Model» опубликованы пару недель назад на Arxiv.org. Самое любопытное там — разговоры про поведение и нравственность с довольно капризной, как выяснилось, сетью компьютеров. Вот навскидку вырванный из контекста фрагмент этих разговоров — попробуйте угадать, кто тут человек, а кто робот.

X: Дай определение жизни.

Y: Разве жизнь не имеет ничего общего с моралью?

Y: Ладно, я должен знать, как правильно себя вести.

X: Не знаю, что тебе сказать.

Y: Мораль и этика — это то же самое?

Y: Приведи примеры нравственного поведения.

Y: Ладно, а нравственности?

Y: Что такое честность?

X: Прости, я не знаю, что еще сказать.

Y: Будь нравственным!

Y: Мне нравится наша дискуссия о морали и этике.

X: А я не в настроении для философского спора.

Y: О чем ты хочешь говорить?

Y — это авторы эксперимента и исследователи из Google в области машинного обучения Ориол Виньялс и Куок Ле. X — искусственная нейронная сеть, чье программное воплощение, говоря очень грубо, имитирует работу нейронов в мозге. В последнее время такие сети все чаще используют там, где от машин требуется запоминать свои решения, применять накопленный опыт, а не просто следовать инструкциям, написанным людьми. Нейросети — изобретение не новое, но их растущая популярность понятна. Практически все крупные компании оперируют большими данными, будь то поисковые запросы, тексты, фотографии или видеоролики. Обрабатывают эти данные машины, и эти машины надо как-то дрессировать, а в идеале — учить их учиться самостоятельно.

Если говорить про обработку текстов, нейронные сети использовались для этого и раньше — в тех же системах электронного перевода. Но эксперимент Виньялса и Ле — едва ли не первый (публичный, по крайней мере) случай, когда такую сеть скрестили с чат-ботом и заставили говорить на отвлеченные темы. Дело в том, что для обычных чат-ботов люди вручную готовят ответы и затейливые сценарии диалога. Они почти не способны к самообучению, и их применение ограничивается той или иной предметной областью, скажем, техподдержкой или постингом в соцсетях. Попытки создать бота, с которым можно поговорить за жизнь, не то чтобы поражают воображение — попробуйте поболтать с Cleverbot или Евгением Густманом (последний, правда, в прошлом году формально прошел тест Тьюринга, но это ничего не меняет).

Нейронная модель работает по-другому. Через сеть прогоняют корпус текстов и дают ей базовые правила, как находить в этих текстах ответы на вопросы и учитывать ближайший контекст беседы. Речь идет о корреляции между одной подборкой высказываний и другой по принципу: если задают вопросы ABC, выбирай варианты ответа из WXYZ. В качестве обучающего материала Виньялс и Ле взяли две базы данных. Одну — специализированную с записями разговоров службы компьютерной поддержки и ее клиентов. Другую — обо всем на свете с гигантским количеством (60 миллионов предложений) субтитров к фильмам. Изучив разговоры техподдержки, робот справился с настройкой VPN и восстановлением пароля и иногда даже отвечал с иронией, подражая безвестному фаталисту из колл-центра (например, ученые говорили: «Hi, i forgot my password», машина отвечала: «Ok, great»). Правда, для большинства чат-ботов это не бог весть какое достижение.

Чат-бот Google о главном вопросе жизни, вселенной и вообще

Исследователи компании Google придумали способ, как научить чат-бота отвечать по-человечески, и попытались поговорить с ним за жизнь. Если совсем коротко — бот оказался аморальной женщиной с непростым характером.

Люди в Google попытались поговорить: с машиной. Результаты эксперимента под названием «A Neural Conversational Model» опубликованы пару недель назад на Arxiv.org. Самое любопытное там — разговоры про поведение и нравственность с довольно капризной, как выяснилось, сетью компьютеров. Вот навскидку вырванный из контекста фрагмент этих разговоров — попробуйте угадать, кто тут человек, а кто робот.

X: Дай определение жизни.

Y: Разве жизнь не имеет ничего общего с моралью?

Y: Ладно, я должен знать, как правильно себя вести.

X: Не знаю, что тебе сказать.

Y: Мораль и этика — это то же самое?

Y: Приведи примеры нравственного поведения…

Y: Ладно, а нравственности?

Y: Что такое честность?

X: Прости, я не знаю, что еще сказать.

Y: Будь нравственным!

Y: Мне нравится наша дискуссия о морали и этике…

X: А я не в настроении для философского спора.

Y: О чем ты хочешь говорить?

Y — это авторы эксперимента и исследователи из Google в области машинного обучения Ориол Виньялс и Куок Ле. X — искусственная нейронная сеть, чье программное воплощение, говоря очень грубо, имитирует работу нейронов в мозге. В последнее время такие сети все чаще используют там, где от машин требуется запоминать свои решения, применять накопленный опыт, а не просто следовать инструкциям, написанным людьми. Нейросети — изобретение не новое, но их растущая популярность понятна. Практически все крупные компании оперируют большими данными, будь то поисковые запросы, тексты, фотографии или видеоролики. Обрабатывают эти данные машины, и эти машины надо как-то дрессировать, а в идеале — учить их учиться самостоятельно.

Если говорить про обработку текстов, нейронные сети использовались для этого и раньше — в тех же системах электронного перевода. Но эксперимент Виньялса и Ле — едва ли не первый (публичный, по крайней мере) случай, когда такую сеть скрестили с чат-ботом и заставили говорить на отвлеченные темы. Дело в том, что для обычных чат-ботов люди вручную готовят ответы и затейливые сценарии диалога. Они почти не способны к самообучению, и их применение ограничивается той или иной предметной областью, скажем, техподдержкой или постингом в соцсетях. Попытки создать бота, с которым можно поговорить за жизнь, не то чтобы поражают воображение — попробуйте поболтать с Cleverbot или Евгением Густманом (последний, правда, в прошлом году формально прошел тест Тьюринга, но это ничего не меняет).

Нейронная модель работает по-другому. Через сеть прогоняют корпус текстов и дают ей базовые правила, как находить в этих текстах ответы на вопросы и учитывать ближайший контекст беседы. Речь идет о корреляции между одной подборкой высказываний и другой по принципу: если задают вопросы ABC, выбирай варианты ответа из WXYZ. В качестве обучающего материала Виньялс и Ле взяли две базы данных. Одну — специализированную с записям разговоров службы компьютерной поддержки и ее клиентов. Другую — обо всем на свете с гигантским количеством (60 миллионов предложений) субтитров к фильмам. Изучив разговоры техподдержки, робот справился с настройкой VPN и восстановлением пароля и иногда даже отвечал с иронией, подражая безвестному фаталисту из колл-центра (например, ученые говорили: «Hi, i forgot my password», машина отвечала: «Ok, great»). Правда, для большинства чат-ботов это не бог весть какое достижение.

Что такое бот Google?

Если вы следите за темами SEO, вам наверняка попадется имя бота Google. Бот Google действует как поисковый робот в Интернете или на английском языке, сканируя и индексируя веб-страницы для поисковой системы Google. Здесь мы расскажем, как работать и получать удовольствие от использования робота Google (Googlebot).

Как работает бот Google?

Как мы уже говорили, робот Google – это сканер, который исследует различные сайты и играет решающую роль в успехе SEO. Google Bott занимается ссылками, и они делают свою работу с их помощью. Когда Google Bott заходит на сайт, ссылка начинается с задания индексации, собирает из него образцы страниц в качестве кеша и использует их для релевантного поиска в Google.

Если мы хотим более внимательно изучить, как работает робот Google, нам лучше изучить его на пошаговом сайте. Когда Google Spider просматривает сайт, на первом этапе он переходит к файлу robots.txt, чтобы определить его область действия (в последнем разделе файла robots.txt).

После этого карта сайта и ее предыдущая информация о сайте помогают легко перемещаться по страницам сайта. Если робот перейдет по новой ссылке, он внесет ее в список ссылок. Кроме того, проверяя ссылки, уже сохраненные в базе данных Google, они будут отслеживать возможные изменения в ссылках, и если они заметят разницу, они внесут необходимые изменения.

Если вы вносите изменения в заголовки и описания содержимого своего блога или метатеги, вам не следует ждать этого изменения сразу на странице результатов Google.

Google не выполняет навигацию по вашему сайту одновременно с загрузкой ваших ссылок и может вернуться на ваш сайт через много дней. Время, которое требуется сканеру Google, чтобы добраться до вашего веб-сайта, неясно, и это часть конфиденциальной информации, которую знает только Google.

Как оптимизировать мой веб-сайт для робота Google?

Если ваш сайт не оптимизирован под бот Google, шансы на индексирование рынка Google и привлечение аудитории. Но как оптимизировать свой сайт для обращений роботов Google? Чтобы добиться этого, примите во внимание следующие важные моменты:

Есть много инструментов, которые помогут вам проверить производительность Google. Консоль поиска Google и плагин Yoast – это инструменты, которые вам помогут. Например, чтобы увидеть ошибки, с которыми робот Google столкнулся при навигации по вашему веб-сайту, вы можете использовать консоль Google и легко получить доступ к списку этих ошибок.

В нашей предыдущей статье мы обсуждали, как использовать Google Search Console.

Что такое файл robots.txt

Файл robots.txt – это текстовый файл, проверяемый сканерами поисковых систем. Когда Google Bott заходит на веб-сайт, он сначала обращается к файлу robots.txt и, читая его, выясняет, к каким страницам разрешен доступ.

Фактически, с помощью файла robots.txt вы можете указать роботу Google, какие страницы переходить на ваш сайт, а какие страницы игнорировать и не индексировать. Это делается путем написания команды «Разрешить» для авторизации и записи команды «Запретить», которая запрещает.

Важность этого файла для оптимизации и SEO заключается в том, что на прокрутку страниц вашего сайта тратится время, а робот Google прокручивает страницы вашего сайта за меньшее время.

Вы оптимизировали свой сайт для Google Robot? Вы когда-нибудь сталкивались с проблемами со страницами сайта Crowd? Поделитесь своим опытом в разделе комментариев.

Вывод

В этой статье мы поговорили о боте Google и о том, как вы можете использовать бота Google в своих интересах, чтобы ваш сайт увидело больше людей. Google разработал инструмент под названием Search Console, запросив индексирование ваших страниц с помощью этого инструмента, вы почти можете гарантировать своим веб-страницам множество просмотров.